Daniel L. Stufflebeam, Ph.D., fue fundador del Centro de Evaluación de la Universidad Estatal de Ohio en 1965 y fue director del mismo hasta el 2002. Stufflebeam es colaborador de renombre en el campo de la evaluación.

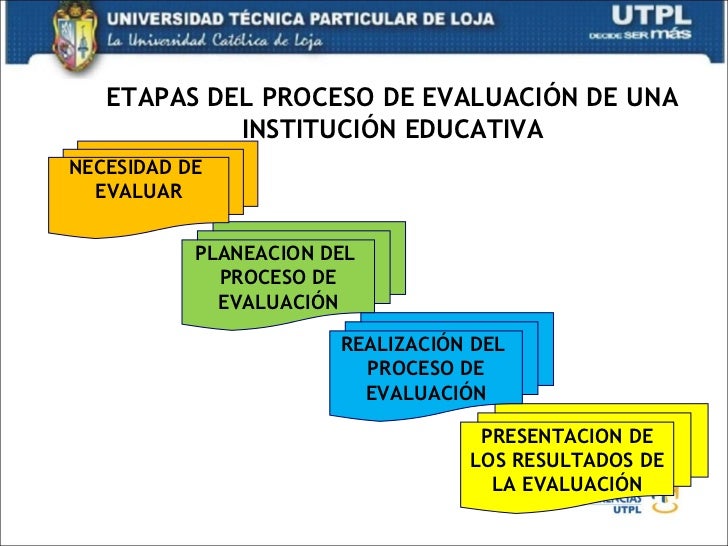

1. INTRODUCCIÓN A LA EVALUACIÓN INSTITUCIONAL 1.1. Definición de evaluación 1.2. Historia de la evaluación 1.3. Los fines de la evaluación institucional 1.4. Las etapas de la evaluación.

Lecturas

http://publicaciones.anuies.mx/pdfs/revista/Revista79_S2A8ES.pdf

https://www.inee.edu.mx/images/stories/2015/revista_red/2407/EntreNotasEB.pdf

1. EVALUACIÓN Y OBJETIVOS 1.1. Procedimiento de diseño evaluativo 1.2. Modelo de evaluación 1.3. La evaluación como proceso 1.4. Limitaciones y desventajas del modelo de evaluación.

Lecturas

https://gobiernoabierto.navarra.es/sites/default/files/2.plan_evaluacion.pdf

1. LA EVALUACIÓN SEGÚN CRONBACH 1.1. Introducción al modelo 1.2. La planificación evaluativa 1.3. Los elementos de la planificación evaluativa 1.4. Los resultados 1.5. El propósito de la evaluación.

Lecturas

https://estherrrivero.blogia.com/2009/041804-la-evaluaci-n-desde-stufflebeam-y-cronbach.php

CRONBACH

Según L.J. Cronbanch (1963),

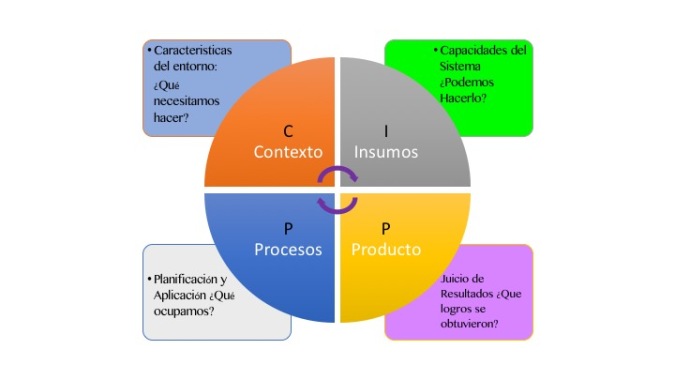

1. EL MODELO DE STUFFLEBEAM 1.1. Introducción al modelo 1.2. Definición del CIPP 1.3. El desarrollo del Modelo CIPP 1.4. Las categorías del CIPP 1.4.1. Evaluación del contexto 1.4.2. Evaluación de entrada 1.4.3. Evaluación del proceso 1.4.4. Evaluación del producto 1.5. La metaevaluación.

Lecturas

https://estherrrivero.blogia.com/2009/041804-la-evaluaci-n-desde-stufflebeam-y-cronbach.php

Daniel L. Stufflebeam, Ph.D., fue fundador del Centro de Evaluación de la Universidad Estatal de Ohio en 1965 y fue director del mismo hasta el 2002. Stufflebeam es colaborador de renombre en el campo de la evaluación.

http://evaluacionparaelperfeccionamiento.blogspot.com/2010/06/quien-es-stufflebeam_07.html

---------------------------------------------------------------------------------------------------------------------------------------------

Daniel Stufflebeam nos deja un importante aporte a la evaluación. Su modelo eminentemente cuantitativo: CIPP. Este modelo fue muy utilizado entre 1965 y los años 80s. Precursor de los modelos evaluativos cuantitativos más recientes como la evaluación de impacto.

------------------------------------------------------------------------------------------------------------------------------

http://entornovirtualparaeldesarrollode.weebly.com/modelo-cipp.html

------------------------------------------------------------------------------------------------------

EL CONCEPTO DE METAEVALUACIÓN

Bajo esta perspectiva la metaevaluación es una fase o etapa, usualmente terminal, del trabajo o proyecto de evaluación: la evaluación de la

evaluación.

https://revistacienciassociales.ucr.ac.cr/images/revistas/RCS92_93/13.pdf

1. EL MODELO DE STAKE 1.1. Introducción al modelo 1.2. Descripción del modelo 1.3. Esquema para la recopilación de datos 1.4. Evaluación respondiente.

La figura más señera de este tipo de evaluación es Stake, quien a su vez puede considerarse una de las figuras americanas más importantes en el campo de la evaluación de los años sesenta.

-------------------------------------------------------------------------------------------------------------------------------------------------------------- Además, Stake planteó un esquema para la recopilación de datos que, --------------------------------------------------------------------------------------------------------------------------------------------------------- EVALUACIÓN RESPONDIENTE: EL MODELO CUALITATIVO DE ROBERT STAKEAlgunos de los aprendizajes que debemos interiorizar, es como se ha mencionado en otras ocasiones, que la evaluación puede recurrir a métodos tanto cuantitativo (tradicionalmente), como a métodos cualitativos. ------------------------------------------------------------------------------------------------------------------------------------------------------ |

1. EL MÉTODO EVALUATIVO DE SCRIVEN 1.1. Introducción al modelo 1.2. Evaluación amateur contra evaluación profesional 1.3. Evaluación intrínseca y final 1.4. La evaluación sin metas 1.5. Valoración de las necesidades 1.6. Los indicadores de la evaluación 1.7. La metaevaluación 1.8. Ideologías evaluativas.

La definición de evaluación

A lo largo de los años, el doctor Scriven ha ido desarrollando su definición de evaluación, pero su mensaje básico sigue siendo el mismo.

En un artículo ya clásico (1967), definía la evaluación como una actividad metodológica que “consiste simplemente en la recopilación y combinación de datos de

trabajo mediante la definición de unas metas que proporcionen escalas comparativas o numéricas, con el fin de justificar 1) los instrumentos de recopilación de datos, 2)

las valoraciones y 3) la selección de las metas”. Al discutir la evolución de su definición de evaluación, le hemos oído decir a menudo que la evaluación, esencialmente,

es la determinación sistemática y objetiva del valor o el mérito de algún objeto, y que las evaluaciones se realizarán mejor contratando a un evaluador independiente

para que emita un juicio sobre algún objeto basándose en pruebas acumuladas procedentes de su comparación con otros objetos distintos a la hora de satisfacer las

necesidades del consumidor. Según este punto de vista, la evaluación es preferentemente comparativa: de ahí que atienda tanto a los costes comparativos como a los

beneficios, se preocupe de cómo satisfacer mejor las necesidades de los consumidores, sea – en el mejor de los casos – una actividad profesional

que incluye procedimientos sistemáticos, deba ser realizada tan objetivamente como sea posible y deba culminar en juicios y recomendaciones.

http://postgrado.una.edu.ve/evaluacionaprendizajes/paginas/stufflebeamcap10.pdf

----------------------------------------------------------------------------------------------

Evaluación amateur contra evaluación profesional

En las primeras etapas de la elaboración de un currículo, Scriven prefiere la “evaluación amateur” (autoevaluación) a

la “evaluación profesional”. Quienes han desarrollado un programa, cuando actúan como sus propios evaluadores, pueden ser un poco sistemáticos y subjetivos, pero

también son solventes, tranquilizantes, dedicados a la consecución del éxito y tolerantes con los objetivos vagos y los procedimientos de desarrollo investigativo. Los

evaluadores profesionales, si intervienen demasiado pronto, pueden “ahogar los fuegos creativos de un grupo productivo”, retardar el proceso de desarrollo urgiendo a

la clarificación de los objetivos o perder su punto de vista objetivo alineándolo demasiado con el esfuerzo productivo, entre otras cosas. Los evaluadores profesionales

son necesarios, sin embargo, para llevar a cabo las evaluaciones formativa y sumativa durante las últimas etapas del desarrollo. Ambos tipos de evaluación requieren un

alto nivel de habilidad técnica y una objetividad que raramente posee el personal que interviene en el desarrollo, pues no está especialmente preparado en la teoría y

metodología evaluativas. Scriven recomienda que un evaluador profesional sea incluido en el personal que interviene en el desarrollo para llevar a cabo la evaluación

formativa, y aconseja muy a menudo que los evaluadores profesionales externos sean los encargados de realizar y presentar las evaluaciones sumativas.

http://postgrado.una.edu.ve/evaluacionaprendizajes/paginas/stufflebeamcap10.pdf

--------------------------------------------------------------------------------------------------------

Evaluación intrínseca y evaluación final

Scriven también distingue entre evaluación intrínseca y evaluación final. La evaluación intrínseca valora las cualidades de una

mediación, sin tener en cuenta los efectos sobre los clientes, juzgando ciertas características como las metas, la estructura, la metodología, las calificaciones y las

actitudes del personal, las facilidades, la credibilidad pública y los informes previos. La evaluación final no se preocupa de la naturaleza del programa, de los libros de

texto, de la teoría o de cualquier otro objeto, sino más bien de sus efectos sobre los clientes. Estos efectos pueden incluir escalas de tests, rendimiento en el trabajo o el

estado de salud. Scriven reconoce la importancia de la evaluación intrínseca, pero destaca que también deben determinarse y juzgarse los resultados, puesto que las

relaciones causales entre las variables del proceso y las de los resultados es rara, o ninguna, la vez en que se conocen a ciencia cierta. Explica que ambos tipos pueden

contribuir tanto a la evaluación formativa como a la sumativa. Es particularmente crítico con las juntas acreditadas, a causa de su preocupación por los criterios

intrínsecos, como el número de libros de una biblioteca, y su fracaso al valorar el trabajo de los graduados.

http://postgrado.una.edu.ve/evaluacionaprendizajes/paginas/stufflebeamcap10.pdf

-----------------------------------------------------------------------------------------

La evaluación sin metas

Dando un paso más en su amplia preocupación por la evaluación basada en las metas, Scriven presenta una propuesta

contraria bajo la denominación de “evaluación sin metas”. Según este método, el evaluador permanece a propósito ignorante de las metas fijadas

para el programa e investiga todos los efectos secundarios que examinar, puesto que los datos acerca de todos los efectos, cualquiera que sea el

propósito del programa, son igualmente admisibles. Si un programa se realiza como se supone que debe realizarse, la evaluación debe confirmar

esto, pero el evaluador, a la vez, podrá descubrir los efectos inesperados que los evaluadores que se basan en las metas pueden olvidar a causa de su

preocupación por las metas prefijadas. En cualquier caso, Scriven dice que la evaluación sin metas es reversible y complementaria: se puede

empezar sin metas, con el fin de investigar todos los efectos, y luego cambiar el método basado en las metas es reversible y complementaria: se

puede empezar sin metas, con el fin de investigar todos los efectos, y luego cambiar el método basado en las metas para asegurar que la evaluación

determinará si las metas han sido alcanzadas. O incluso pueden realizarse simultáneamente ambos tipos de evaluación por diferentes evaluadores.

Las ventajas de la evaluación sin metas, según Scriven, consisten en que es menos instructiva que la evaluación basada en metas; más adaptable a

los cambios de metas repentinos; más solvente a la hora de encontrar efectos secundarios; menos propensa a la tendenciosidad social, perceptiva o

cognitiva; más estimulante profesionalmente; y más equitativa a la hora de tener en cuenta una amplia gama de valores. En general, nosotros

creemos que la evaluación sin metas es una técnica renovadora – no un modelo – que puede ayudar a llevar a cabo el método evaluativo orientativo

hacia el consumidor.

http://postgrado.una.edu.ve/evaluacionaprendizajes/paginas/stufflebeamcap10.pdf

---------------------------------------------------------------------------------------------------------

Valoración de las necesidades

Una de las dificultades de utilizar la evaluación sin metas se refiere a cómo asignar un significado valorativo a los resultados. Si los

objetivos se identifican sin hacer caso de lo que se está tratando de lograr, ¿cómo se pueden separar las consecuencias deseadas de las indeseadas? La respuesta se

Scriven es que deben compararse los resultados observados con las necesidades valoradas de los consumidores. Pero si una necesidad es una discrepancia entre algo

real y algo ideal, y si un ideal es una meta, ¿no están las valoraciones de las necesidades basadas en metas, y, por lo tanto, no están también las evaluaciones sin metas

basadas en metas? Scriven dice que no. Para empezar, las metas no deben coincidir necesariamente con cualquier grupo de ideales como los incluidos en una

democracia. En cualquier caso, afirma que la concepción clásica de la necesidad, como discrepancia entre algo real y algo ideal, es errónea, puesto que los ideales a

menudo son ilusorios. Dado que las necesidades de los consumidores son un concepto fundamental en este método, sus estudiantes y él conceptualizaron ampliamente e

investigaron este concepto. Para Scriven, una necesidad es “cualquier cosa que sea esencial para un modo satisfactorio de existencia, cualquier cosa sin la cual este

modo de existencia o nivel de trabajo no puede alcanzar un grupo satisfactorio”. Los ejemplos que utiliza, por lo general, son la vitamina C y la alfabetización. Cuando

no dispone de esto, una persona puede estar físicamente enferma o social e intelectualmente debilitada; de ahí que la persona lo necesite. Para Scriven, la valoración de

las necesidades es un proceso para descubrir hechos acerca de si no proporcionar o arrebatar ciertas cosas puede tener funestas consecuencias, todo ello basado en

normas razonables sobre lo que es bueno y lo que es malo. Dados los resultados de una valoración de necesidades, pueden juzgarse los resultados de un programa

concreto como buenos, malos o indiferentes, dependiendo de si contribuyen o no a satisfacer las necesidades identificadas. Según nuestra experiencia, este argumento

es, actualmente, más convincente en el terreno filosófico que en el práctico. Se necesita un alto grado de desarrollo en el nivel técnico antes de que la valoración de las

necesidades pueda producir significados factibles y apropiados para juzgar los resultados.

http://postgrado.una.edu.ve/evaluacionaprendizajes/paginas/stufflebeamcap10.pdf

-----------------------------------------------------------------------------------

La lista de control de indicadores de la evaluación

La lista de control de indicadores sintetiza las primeras ideas de Scriven. Refleja su concepto de que la evaluación supone múltiples dimensiones, debe emplear

múltiples perspectivas, introducir múltiples niveles de valoración y utilizar múltiples métodos. De ahí que se haya referido a veces a la lista de control de indicadores

como el multimodelo de evaluación. Sus dieciocho puntos son los siguientes:

1. Descripción. ¿Qué hay que evaluar? El evaluado, descrito tan objetivamente como sea posible. ¿Cuáles son sus componentes? ¿Cuáles son sus relaciones?

2. El cliente. ¿Quién ha encargado la evaluación? El cliente evaluativo, que puede o no ser el iniciador de la investigación evaluativa, puede o no ser el instigador del

evaluando – por ejemplo, su fabricante, o la agencia subvencionadora, o su padrino legislativo – y puede o no ser su inventor –por ejemplo, el planificador de un

producto o programa.

3. Antecedentes y contexto de a) el evaluando y b) la evaluación. Incluye la identificación de los mantenedores (incluyendo los no-clientes

enumerados en el punto 2, el patrocinador, los representantes de la comunidad, etc).

4. Recursos (“sistemas de ayudas” o “valoración de los

efectivos”) a) disponibles para la utilización del evaluando, b) disponibles para la utilización de los evaluadores. No se trata de lo que se utiliza, por ejemplo, en las

compras o el mantenimiento, sino de lo que puede utilizarse.

5. Función. ¿Qué hace el evaluando? Distinguir entre lo que se supone que hace – función o papel propuesta o

declarada- y lo que de hecho hace (función real, tanto para el evaluador como para el consumidor).

6. Sistemas de distribución. ¿Cómo llega al mercado el evaluando?

¿Cómo se mantiene (en servicio)? ¿Cómo se perfecciona (se pone al día)? ¿Cómo son sus usuarios? ¿Cómo se lleva a cabo su realización, control y perfeccionamiento?

¿Quién hace todo esto?

7. El consumidor. ¿Quién utiliza o recibe (los efectos de) el evaluando? Distinguir las poblaciones o consumidores escogidos- mercado deseado

– de las poblaciones de consumidores directamente afectadas de una manera real o potencial – el verdadero mercado- o consumidores o receptores (o clientes del

evaluando, a menudo llamados clientela).

8. Las necesidades y valores de los afectados y potencialmente, impactados. Esto incluye tanto los deseos como las necesidades, y también los valores como las normas

sobre el mérito y los ideales juzgados o supuestos (véase punto 9).

9. Normas. ¿Existen normas preexistentes y objetivamente valoradas, acerca del mérito o el

valor, que deban aplicarse? ¿Procede alguna de ellas del cliente y el consumidor, de la función y de las necesidades/valores?

10. El proceso. ¿Qué

limitaciones /costes /beneficios se aplican a la operación normal del evaluando (no a sus efectos o resultados del punto 11)? En particular: legales/ético- morales

/políticas/administrativas/estéticas / hedónicas /científicas. Un proceso administrativo tiene limitaciones especialmente significativas en lo que se refiere al “grado de

realización”.

11. Resultados. ¿Qué efectos ha producido el evaluando (deseados o indeseados)? Resulta

útil una matriz de efectos: población afectada X tipo de efecto (cognitivo / afectivo /psicomotor / sanitario / social / ambiental) X por la puntuación de las Z de tiempo

de reacción (inmediata /al final del tratamiento / más tarde) X duración X cada componente o dimensión (si se requiere la evaluación analítica).

12. Posibilidad de generalización a otras personas / lugares /tiempos / versiones. “Personas” significa tanto el personal como los receptores. Esto también

puede denominarse posibilidad de distribución, posibilidad de venta / exportación / duración / modificación.

13. Costes. En dólares –psicológico – de personal; inicial –repeticiones (incluyendo preparación, mantenimiento y perfeccionamiento); directo / indirecto- inmediato

/retardado / rebajado; si conviene, por componentes.

14. Comparaciones con opciones alternativas, incluyendo las opciones reconocidas y las no reconocidas, las

disponibles y las que se pueden crear. Los principales contendientes en este campo son los “competidores críticos” y se identifican en términos de coste más

efectividad. Normalmente incluyen a aquellos que producen efectos similares o mejores por un precio menor, y mejores efectos por un coste extra razonable (recursos).

15. Significado. Una síntesis de todo lo anterior. La validación del procedimiento sintético es, a menudo, una de las tareas evaluativas más dificultosas. Normalmente,

no puede dejarse al cliente que, por lo general, está mal equipado en experiencia y objetividad; y las fórmulas – por ejemplo, los cálculos de costebeneficio- rara vez

resultan adecuadas. Lo más útil es una flexible suma ponderada.

16. Recomendaciones. Esto puede o no ser requerido, y puede o no desprenderse de la evaluación;

aunque sean requeridas, puede que no sea posible proporcionar ninguna puesto que los únicos tipos que pueden resultar apropiados no disponen de pruebas científicas

específicas en el campo de la investigación. (Los recursos disponibles para la evaluación resultan cruciales aquí).

17. El informe. El vocabulario, la extensión, el diseño,

el medio, la localización y el personal para su presentación necesitan un cuidadoso examen, igual que la protección /privacidad / publicidad y la investigación previa o

la circulación de los borradores finales o preliminares.

18. la metaevaluación. La evaluación debe ser evaluada preferiblemente antes de a) su realización, b) la difusión

final del informe. La evaluación externa es deseable, pero primero del evaluador principal debe aplicar la lista de control de indicadores a la propia evaluación. Los

resultados de la metaevaluación deben ser utilizados formativamente pero también pueden ser incorporados al informe o trasmitidos (resumidamente) al cliente y otras

audiencias adecuadas. (Las “audiencias” aparecen en el metapunto 7, puesto que son el “mercado” y los “consumidores” de la evaluación.)

Estas etapas no están

concebidas para ser aplicadas en una secuencia concreta, pero deben ser planteadas antes de que se lleve a cabo la lista de control de indicadores. Igualmente, un

evaluador puede recorrer la lista de control muchas veces durante la evaluación de un programa. Los primeros recorridos constituyen la evaluación formativa; los

últimos son lo que Scriven llama “evaluación sumativa”. La base lógica de la lista de control de indicadores es que la evaluación es esencialmente un proceso de

reducción de datos en el que se obtienen grandes cantidades de datos para luego valorarlos y sintetizarlos en un juicio de valor global. Al describir este proceso de

reducción de datos, Scriven sugiere que las primeras etapas ayuden a caracterizar un programa o producto, mientras que las últimas pueden ayudar a valorara su

validez.

http://postgrado.una.edu.ve/evaluacionaprendizajes/paginas/stufflebeamcap10.pdf

---------------------------------------------

La metaevaluación

El punto final de la lista de control de indicadores pide la evaluación de la evaluación. Scriven introdujo este concepto en 1968, cuando publicó un

artículo respondiendo a las preguntas de cómo se evaluaban los instrumentos de la evaluación. Dice que ésta es una de las muchas preocupaciones de la evaluación y

destaca que los evaluadores tienen la obligación profesional de que las evaluaciones propuestas o finalizadas estén sujetas a una evaluación competente. Su base

racional es que la “evaluación es un tema particularmente autorreferente puesto que se aplica a todos los esfuerzos humanos serios y, en consecuencia, a la propia

evaluación”. Advierte que la metaevaluación puede ser formativa, si ayuda al evaluador a planificar y realizar una evaluación solvente, o sumativa, si proporciona al

cliente pruebas independientes acerca de la competencia técnica del evaluador principal y de la solvencia de sus informes. Las sugerencias metodológicas de Scriven

para la realización de metaevaluaciones incluyen la utilización de su lista de control de indicadores de la evaluación, para valorar una evaluación como producto, de

otras listas de control o de otras normas evaluativas profesionales.

http://postgrado.una.edu.ve/evaluacionaprendizajes/paginas/stufflebeamcap10.pdf

--------------------------------------------------------------------------------------------------------

Ideologías evaluativas

Como se ha visto en el material precedente, Scriven es uno de los críticos más reflexivos y expresivos de los conceptos evaluativos predominantes. En coherencia con

esta postura crítica, ha destacado que la evaluación es un tema particularmente autorreferente, lo cual está de acuerdo con su recomendación de la metaevaluación. En

un texto reciente, clasifica los conceptos evaluativos establecidos en cuatro grupos y critica cada uno de ellos extensamente, con la esperanza de convencer a los

evaluadores de que reconozcan y renuncien a ciertas tendencias que, según él, han debilitado el trabajo evaluativo. Luego utiliza su análisis de las virtudes y defectos de

cada método para perfeccionar la base lógica de su lista de control. Describe este modelo como algo que abarca las mejores características de las demás proposiciones

serias acerca de cómo hacer una evaluación, evitando al mismo tiempo las imperfecciones que él identifica en las otras propuestas. Creemos que esto puede ayudarle a

conocer más a fondo la filosofía evaluativa de Scriven, en general, y la lista de control de indicadores de la evaluación en particular, si examina con cuidado su análisis

de las ideologías alternativas. Por lo tanto, vamos a intentar definir sus aspectos más sobresalientes con relación a las cuatro ideologías. Estas ideologías son la

separatista, la positivista, la administrativa y la relativista.

http://postgrado.una.edu.ve/evaluacionaprendizajes/paginas/stufflebeamcap10.pdf

--------------------------------------------------------------------------------------------------------

1. LA ACREDITACIÓN Y CERTIFICACIÓN 1.1. Definición de acreditación y certificación 1.2. La acreditación en estados unidos 1.3. La acreditación y certificación en México 1.4. Los organismos acreditadores y certificadores 1.5. El autoestudio 1.6. La elaboración del autoestudio 1.7. Indicadores 1.8. Criterios de evaluación 1.9. Diagnóstico.

Acreditación y certificación

http://www.fao.org/3/ad094s/ad094s03.htm

-----------------------------------------------------

La Comisión de Acreditación de la Calidad de la Educación (EQAC) concede acreditaciones con el objetivo de asegurar que la enseñanza proporcionada por las instituciones de educación superior cumpla ciertos niveles de calidad académica.

Las acreditaciones se otorgan a cualquier instituto o universidad que esté dispuesto a hacer el esfuerzo de preparar un informe exhaustivo de auto-evaluación que certifique la calidad de su educación. Sin embargo, son muchos los interesados porque aporta un gran valor competitivo entre los institutos y universidades que operan en Estados Unidos.

En otros países, la acreditación educativa americana funciona igual que otras opciones de acreditaciones educativas de ámbito internacional, que avala y le brinda prestigio a las instituciones en un mercado mundial competitivo y globalizado.

-----------------------------------------------------------------------------------------------------------------------------------------------------------

Acreditación y certificación en México

https://www.redalyc.org/pdf/342/34202604.pdf

-------------------------------------------------------------

Organismos acreditadores y certificadores

https://www.monografias.com/docs/Organismos-acreditadores-y-certificadores-P3CVWCPZMZ

------------------------------------------------------------------------------------------------------------------------------

El autoestudio

http://www.eumed.net/tesis-doctorales/2010/amgdm/El%20Autoestudio.htm

----------------------------------------------------------------------------------------------------

Guía para la elaboración del autoestudio

https://prezi.com/vxwyjqpujolz/guia-para-la-elaboracion-del-autoestudio/

-----------------------------------------------------------------------------------------------

Indicadores: Autoestudio Institucional. La institución deberá elaborar el autoestudio institucional con el objeto de valorar qué se tiene y cuál es la brecha que existe entre dónde está y dónde debería estar. Para ello, resulta importante hacer un análisis, definiendo cuáles son los principales problemas, cuáles son las fortalezas que poseen, y las acciones a realizar para superar las deficiencias detectadas. Éstas deberán realizarse en equipo con toda la comunidad educativa del mismo.

https://es.scribd.com/doc/113910206/AUTOESTUDIO-INSTITUCIONAL

-------------------------------------------------------------------------------------

Los Criterios de Evaluación

En la evaluación del aprendizaje con un enfoque educativo con orientación por competencias, ya sea para programas de estudio por asignaturas o con estructura modular o también para cursos específicos, es un requerimiento necesario y complementario a la tarea evaluadora el establecer criterios de evaluación para los diferentes objetivos o aprendizajes esperados, planteados en los diferentes programas de asignaturas o cursos.

Los criterios de evaluación, deben entenderse como indicadores concretos de aprendizaje, los cuales deberían demostrar los alumnos como producto del proceso enseñanza y aprendizaje.

También debe considerárselas como parámetros o patrones, los cuales son utilizados para designar una base de referencia para el juicio de valor que se establece al evaluar.

Los criterios definen “lo que se espera” de algo que se evalúa, es decir, que por medio de estos se puede realizar la “lectura” del objeto evaluado y compararlo con un referente o estándar de desempeño. En este sentido, establecen el nivel requerido y esperado de los aprendizajes y definen cuándo se considera que un alumno y alumna ha conseguido un objetivo determinado.

https://educrea.cl/formular-los-criterios-evaluacion/

-------------------------------------------------------------------

Diagnóstico

https://definicion.de/diagnostico-educativo/

--------------------------------------------------------

Actividad:

Descripción: a partir de las lecturas seleccionadas, la tarea consiste en elaborar una investigación de cuartilla y media sobre: El autoestudio.

Características de presentación:

Incluir hoja de presentación, textos justificados, interlineado (1.5), citas textuales mayores y menores a 40 palabras, relativas y comentarios como lo indicado en clase, times new roman 12 y bibliografía con las marcas de autor no justificados no interlineados.

1. LOS RESULTADOS 1.1. La utilidad de los resultados 1.2. Los resultados como base para el cambio 1.3. Los programas de desarrollo institucional.

Programas de desarrollo institucional

http://sgc.uaeh.edu.mx/planeacion/images/documentos/Guia%20programas%20de%20desarrollo.pdf

----------------------------------------------------------------------------------------------------------------------------

Make a free website with Yola